Informatyka - Maciej Dymarski

"Od zera... do komputera"- folder do ekspozycji

"Od zera... do komputera"- folder do ekspozycji

Historia

komputera -kalendarium

Historia

komputera -kalendarium  Generacje komputerów

Generacje komputerów

Humor komputerowy

Humor komputerowy góra strony

"Od zera ... do komputera" - folder do ekspozycji

ZERO

Czym jest zero ?

To najmniejsza z cyfr . Najstarsze dokumenty zawierające znaki liczb sięgają czwartego tysiąclecia p.n.e . Niepodobna ustalić kiedy pojawił się znak graficzny i pojęcie zera , ale stało to się zdecydowanie później . Wyraz zero pochodzi od arabskiego wyrazu sifr oznaczającego zero. Zero nie jest jednak wynalazkiem arabskim. Arabowie zaczerpnęli je od Hindusów ( tak jak i pozostałe cyfry) a ponieważ byli narodem, dzięki któremu ten system zapisywania cyfr przeniknął do Europy, stąd zwyczaj panujący do dzisiaj nazywania ich "arabskimi". Zero pojawia się w dziele uczonego indyjskiego Arjabhaty "Surjasiddhanta", które to dzieło w zachowaniu swej postaci sięga V wieku. Użyty jest tam termin siunia , który znaczy pustkę - zero. Zero było zapisywane początkowo jako punkt, jeszcze dziś w Turcji , Egipcie i krajach Bliskiego wschodu zero zapisuje się w kształcie kropki czworokątnej.

Ludzkości potrzebne było ponad cztery tysiące lat, by od momentu posłużenia się liczbami, posłużyć się również pojęciem i symbolem zera.

Ale czemu tu się dziwić, zero - coś czego nie ma - kto z nas to rozumie?

Czy można to w ogóle zrozumieć ?

SYSTEMY LICZENIA

Dlaczego chcę tutaj mówić o systemach liczenia ?

Otóż komputery wykorzystują inny system liczenia niż ten, z którego korzystamy na co dzień.

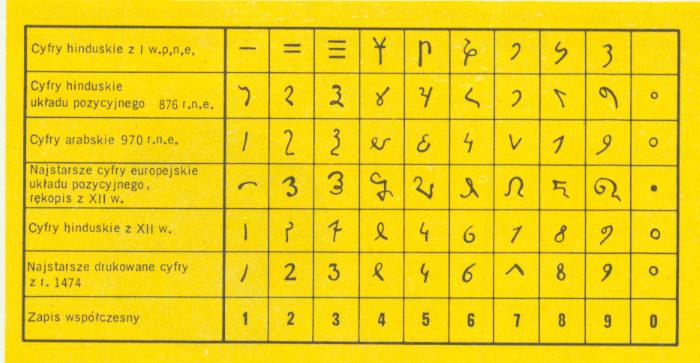

Na co dzień posługujemy się systemem dziesiątkowym. Potrzebne nam jest do tego dziesięć cyfr : 1,2,3,4,5,6,7,8,9 i oczywiście nasze ulubione zero. Znaki graficzne oznaczające poszczególne cyfry zmieniały się na przełomie wieków.

Tablica znaków graficznych cyfr

Dlaczego posługujemy się systemem dziesiątkowym ?

Można próbować się domyślić. Człowiek posiada dziesięć palców i zanim powstały jakiekolwiek urządzenia do liczenia, palce zawsze były "pod ręką"

Liczba dziesięć jako podstawa liczenia, liczba dziesięć a więc również jej wielokrotności - sto, tysiąc, milion - czyli 102, 103, 106

Pewien problem się zaczyna się pojawiać, gdy używamy dużych liczb, chodzi przede wszystkim o nazwy dla tych liczb.

Tysiąc tysięcy to milion - nazwa używana przez Rzymian.

Ta końcówka lion oraz wyrazy łacińskie i mamy gotowe nazwy dużych liczb a więc:

Milion milionów = 1012 = 102·6 (podwójnie do szóstej czyli po łacinie bis+lion daje nam nazwę:) bilion

Milion bilionów = 1018 = 103·6 (trzy - tres) trylion

Milion trylionów = 1024 = 104·6 (cztery - quattour) kwadrylion

Milion kwadrylionów = 1030 = 105·6 (pięć - quinque) kwintylion

Milion kwintylionów = 1036 = 106·6 (sześć - sex) sekstylion

Milion sekstylionów = 1042 = 107·6 (siedem-septem) septylion

Milion septylinów = 1048 = 108·6 (osiem-octo) oktylion

Milion oktylionów = 1054 = 109·6 (dziewięć-novem) nonylion

Milion nonylionów = 1060 = 1010·6 (dziesięć-docem)decylion

A już całkiem duża liczba np.

10600 = 10100·6 ( centrum - sto ) centylion

Niestety nie we wszystkich krajach nazwa liczby odzwierciedla tę samą wartość liczby np. dla nas - miliard to tysiąc milionów czyli 109 natomiast w Ameryce przez miliard rozumie się 108 a więc sto milionów.

Dlatego jednak najlepiej zapisywać liczby w postaci potęgi liczby dziesięć.

Wszystkie systemy liczenia ( bo można liczyć używając innych systemów niż dziesiętny - lecz o tym za chwilę ) są systemami pozycyjnymi.

Cyfra w zależności od pozycji na jakiej stoi ma odpowiednią wagę.

Czyli mamy w systemie dziesiątkowym pozycję jedności, dziesiątek, setek, tysięcy itd.

Dla przykładu liczba 3679 to 9 jedności, 7 dziesiątek, 6 setek i 3 tysiące i to jest dla nas oczywiste.

Jak by wyglądała ta liczba gdybyśmy zapisali ją w postaci sumy iloczynów?

3679= 3 · 1000 + 6 · 100 + 7 · 10 + 9 · 1

lub w odwrotnej kolejności (prawo przemienności)

9 · 1 + 7 · 10 + 6 · 100 + 3 · 1000

a to można zapisać

9 · 100 + 7 · 101 + 6 · 102 + 3 · 103

w dalszym ciągu jest to liczba 3679

powstaje więc ogólny wzór na wartość liczby zapisanej w systemie dziesiątkowym

w=b0 · 100 + b1 · 101 + b2 · 102 + ··· + bn · 10n gdzie bn - cyfra stojąca na n-tej pozycji

Po co ten wzór?

Żeby lepiej zrozumieć, że można używać dowolnego systemu liczenia.

Liczba to ciąg cyfr używanych w danym systemie, wartość każdej z nich zależy od pozycji, na której stoi, a waga pozycji zależy od kolejnej potęgi podstawy systemu.

W systemie dziesiątkowym podstawą systemu jest dziesięć i tyloma cyframi też system się posługuje.

Co będzie podstawą w systemie dwójkowym ?

Oczywiście - dwa i będą tylko dwie cyfry ( 0,1 ).

A w piątkowym ? -pięć i cyfry ( 0,1,2,3,4 ),

w szesnastkowym - szesnaście i cyfry (0,1,2,3,4,5,6,7,8,9,A,B,C,D,E,F) - że tu pojawiły się litery - po po prostu łatwiej było przyjąć znane znaki graficzne, niż wymyślać jakieś nowe oznaczenia cyfr) itd.

Można liczyć w dowolnym systemie.

My krótko spojrzymy na system dwójkowy - bo jak się okazuje takim systemem posługuje się nasz komputer.

Dlaczego przyjęto system dwójkowy ?

Z czysto praktycznych względów - łatwiej technicznie jest rozpoznać dwa stany ( np. impuls elektryczny lub jego brak a więc 1 lub 0 ) niż dziesięć różnych stanów. Poza tym przy przesyle informacji nawet przy dużych zniekształceniach musimy tylko stwierdzić czy jest impuls czy go nie ma ( czy jest nośnik magnetyczny namagnesowany czy nie - dyskietka, czy jest na nośniku optycznym wgłębienie czy go nie ma - płyta CD ) co w konsekwencji daje nam pewność przesyłu i zapisu informacji.

A system dwójkowy równie dobrze nadaje się do zapisu liczb i operacji na nich jak system dziesiątkowy.

Naszej wyobraźni przyzwyczajonej do dziesiątkowego jest tylko to trudniej przyswoić.

System dwójkowy czyli każda liczba zapisana jest przy pomocy cyfr 0 i 1

Weźmy np. taką liczbę 10011 na pierwszy rzut oka nie znamy jej wartości,ale znamy przecież wzór, trzeba tylko zamienić w nim podstawę potęgi z 10 na 2 i już mamy nowy wzór :

W=b0 · 20 + b1 · 21 + b2 · 22 + ··· + bn · 2n

trzeba tylko pamiętać o tym, że jest to system pozycyjny i wpisując cyfry z konkretnej liczby musimy je wpisać na odpowiedniej pozycji ( zaczynając od prawej - od pozycji najmniej znaczącej),

a więc jaką wartość w systemie dziesiątkowym ma liczba 10011

W=1 · 20 + 1 · 21 + 0 · 22 + 0 · 23 + 1 · 24

a więc

W = 1 · 1 + 1 · 2 + 0 · 4 + 0 · 8 + 1 · 16

W = 19 czyli jesteśmy w stanie zrozumieć już teraz wartość liczby 10011 A zatem liczba zapisana jako 10011 w systemie dwójkowym to liczba 19 w systemie dziesiątkowym. Proste - prawda ?

Przy odpowiedniej wprawie zauważymy,

że 11111 to liczba 31

a 11111111 to liczba 255

trzeba tylko znać kolejne potęgi liczby 2 i już.

Nie ma jednak takiej potrzeby przeliczania, komputer świetnie sam sobie poradzi z systemem dwójkowym.

Widać teraz jak ważne jest tu zero, to połowa systemu.

Komputer posługując się systemem dwójkowym przetwarza i wykonuje operacje na ciągach zero - jedynek.

Związane są z tym pojęcia bit i bajt - podstawowe dla informatyki.

Bit(binary digit - cyfra dwójkowa) to podstawowa jednostka informacji, może przyjmować umowne wartości 0 lub 1 i odpowiada dwóm rozróżnialnym stanom nośnika elektrycznego, magnetycznego, optycznego itd.

Bajt(binary term - wyrażenie dwójkowe) to najmniejsza jednostka pamięci - składa się z 8 bitów i przy przechowywaniu informacji znakowej umożliwia zapisanie jednego znaku graficznego (oczywiście dzieje się to w kodzie ASCII).

Wielokrotności bajta to kilobajt, megabajt, gigabajt.

Ponieważ mamy do czynienia z systemem dwójkowym to 1 kilobajt nie jest równy 1000 bajtów lecz 1024 bo podstawą liczenia w systemie dwójkowym jest liczba 2 a 210 to właśnie 1024

MASZYNY LICZĄCE

Ludzie na pewnym etapie swojego rozwoju doszli do momentu, gdy nie wystarczyły już do liczenia ręce i rozpoczął się w historii ludzkości rozdział przyrządów, później maszyn, wspomagających liczenie.

Pierwszym takim przyrządem był stosowany przez Greków a później Rzymian ( wspomniany przez historyka greckiego Herodota - V wiek p.n.e.) abacus ( abak)

Prosta deska, na którą sypano piasek, przeciągano równoległe i w jednakowych odstępach rysy a rachunki wykonywano za pomocą kamyków.

Poszczególne kolumny oznaczały jedności, dziesiątki, setki itd. Następny krok to zamiast piasku zrobiono wyżłobienia w desce a zamiast kamyków pojawiły w tych wyżłobieniach przesuwane kulki. Przy pomocy abakusa potrafiono dodawać, odejmować i mnożyć.

Na podobnych zasadach jak abacusa były oparte wykorzystywane w innych krajach przyrządy do liczenia np. w Japonii - soroban, w Chinach - swanpan, w Rosji - szczoty, w Polsce - liczydła.

Popularne do dzisiaj liczydło

W Persji, Chinach, krajach Amerkyki Południowej używano jako pomocy do liczenia węzłów wiązanych na sznurkach przykładem może być liczydło sznurowane używane przez Inków - quipu (czyt. Kipu)

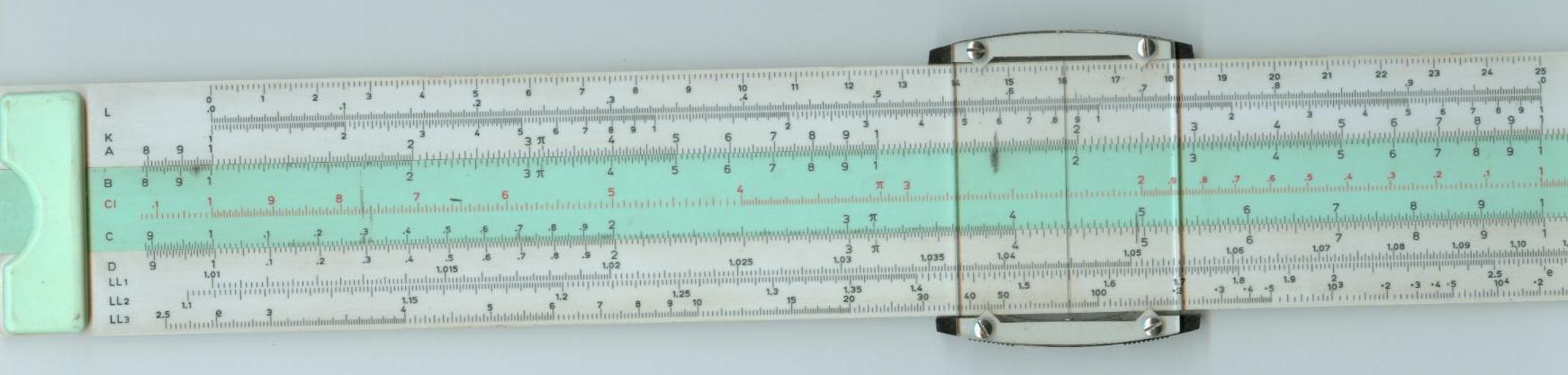

Kolejny krok to stosowanie przy obliczeniach przybliżonych (do trzech cyfr znaczących) suwaków logarytmicznych. Wykonane najczęściej z drewnianych listewek połączonych brzegami tak aby mogły się swobodnie przesuwać. Na obu jest naniesiona odpowiednia skala. Manewrując listewkami można mnożyć, dzielić, potęgować lub pierwiastkować zarówno liczby całkowite i ułamkowe.

Suwak logarytmiczny wykonany z tworzywa sztucznego

Pierwsze mechaniczne urządzenia dla celów obliczeniowych pojawiły się w XVII wieku.

N I E K T

Ó R E

E K S

P O N A T Y

Z

E K S P O Z Y C J I

:

Maszyna

zwana popularnie "kręciołkiem" typ KR-13 , wyprodukowana przez polskie

Zakłady Metalowe Predom Mesko

Bardziej

rozbudowany "kręciołek", maszyna wyprodukowana w chińskich zakładach

SHANGHAI CALCULATOR & TYPEWRITER MFG. WORKS o nazwie Flaying

Fish Calkulator - typ JSY 20

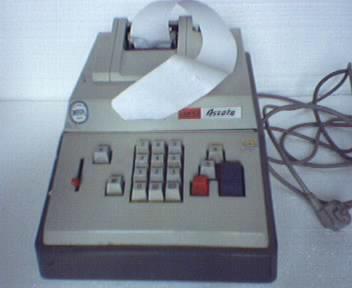

Maszyna

elektryczna z taśmą papierową wyprodukowana przez I.I.S. ELEKTRO MURES

TG.-MURES

Ascota

314 - wyprodukowana przez BUROMASCHINEN-EXPORT GMBH

Przenośna

maszyna do pisania "Olympia"

Typowa

gra telewizyjna - urządzenie specjalnie skonstruowane do grania,

podłączane do telewizora, dopinając cartridge'a można było wymieniać

gry

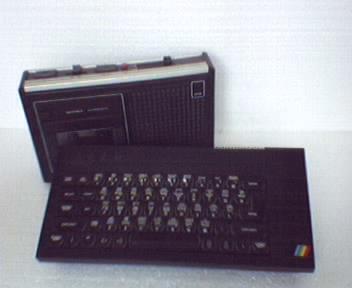

Jeden

z pierwszych komputerów domowych ZX-Spectrum popularnie

nazywany "trumienką" ze względu na kształt, dane czytane z taśmy

magnetycznej ze zwykłego magnetofonu kasetowego, jako monitor

mógł służyć telewizor

TIMEX

COMPUTER 2048 - podobnej klasy komputer co ZX-Spectrum - służący przede

wszystkim do gier, można było pisać programy w języku BASIC

Bardzo

popularny w Polsce komputer, na którym ja również

stawiałem pierwsze kroki, COMMODORE-64 , krótko C-64

posiadający rewelacyjną pojemność pamięci RAM - 64 kilobajty

. Firma Commodore produkowała specjalnie magnetofony do swoich

zestawów

Firma

Schneider magnetofon umieściła w tej samej obudowie co komputer ( CPC

464 ), do zestawu wyprodukowano monitor (Green Monitor GT 65)

Kolejnym

krokiem firmy Schneider ,gdy nośnikami informacji stały się dyskietki

było umieszczenie w tej samej obudowie stacji dysków

(Nowością był zaproponowany przez firmę standard dyskietek 3''

W

momencie wprowadzenia dyskietek zamiast magnetofonu do komputera

podłączano stację dysków - stacja dysków na

dyskietkę 5,25''

Podwójna

stacja dysków do komputera firmy Schneider na dyskietki 3''

A

tak wyglądała ewolucja dyskietek : dyskietka 8'', dyskietka 5,25'',

dyskietka 3,5'' (obecnie istniejący standard), i dyskietka 3'' oraz

płyty CD - nowy nośnik, który na dobre zadomowił się na

rynku.

góra strony

Informacje zebrane z literatury i prasy technicznej umieściłem w poniższym zestawieniu

Historia komputera - kalendarium

| 3000 p.n.e. | - Wczesna forma liczydeł używana w Azji | ||

| 876 n.e. | - Pierwsze, zarejestrowane w Indiach, użycie symbolu 0 | ||

| 1620 r. | - Edmund Gunter z Anglii wynajduje suwak logarytmiczny, który stanie się protoplastą kalkulatora | ||

| 1623 r. | - Wilhelm Schickald - buduje drewniane urządzenie dodające liczby kilkucyfrowe | ||

| 1642 r. | - Blaise Pascal projektuje pierwszy mechaniczny sumator, zwany później "pascaliną" który buduje żeby ulżyć w pracy swojemu ojcu-celnikowi | ||

| Początek XVII w. | - John Neper pisze dzieło o logarytmach ,opracowuje system wspomagający wykonywanie mnożenia zwany "pałeczkami Nepera" -sprowadzenie mnożenia do serii dodawań | ||

| 1673-79 (1694 r.) | - Gotfried Leibniz konstruuje prymitywny arytmometr wykonujący cztery działania ( odkrył na nowo pochodzący ze starożytnych Chin system dwójkowy) | ||

| 1728 r. | - Falcon zastosował kartę perforowaną w automatycznym krośnie tkackim ale dopiero krosna Jacquarda w 1798 r. odniosły sukces, kod dziurkowy zamieniał się na żądany wzór | ||

| 1769-1842 | -Abraham Stern (zegarmistrz) konstruuje serię maszyn,które oprócz działań podstawowych wyciągały pierwiastki | ||

| 1812 r. | - Robotnik Ned Ludd zachęca innych robotników, by zniszczyli maszyny zastępujące człowieka, gdyż obawia się utraty pracy. Terminu "Luddite" używano później na określenie oponentów technologii. | ||

| 1832 r. | - Charles Babbage - pomysł maszyny różnicowej -mechaniczny kalkulator składający się z 25 tys.elem. z metali kolorowych ,dokładność do 21 miejsc po przecinku - zbyt kosztowna budowa na możliwości Babbage'a, zmontowano tylko fragment złożony z 2 tys. elementów ( w 1991 r. Science Museum odtworzyło maszynę różnicową -też fragment). | ||

| 1834 r. | - Charles Babbage projektuje pierwszy komputer sterowany instrukcjami zewnętrznymi wykorzystując karty perforowane ( maszyna analityczna ). Niestety, z powodu braku funduszy komputer nigdy nie zostaje zbudowany. | ||

| 1854 r. | - George Boole publikuje uwagi na temat symboli logicznych, które sto lat później staną się podstawą działania komputerów. | ||

| 1857 r. | - Sir Charles Wheatstone wprowadza taśmę papierową w rolkach, która może służyć do zapisywania i odczytywania danych | ||

| 1876 r. | - Aleksander Graham Bell w wieku 27 lat opatentowuje wynalazek telefonu | ||

| 1890 r. | - Herman Hollerith projektuje maszynę wykorzystującą karty dziurkowane ( tabulator), co pozwala amerykańskim instytucjom zajmującym się spisami ludności zredukować czas obliczania danych z dziesięciu lat do dwu i pół roku | ||

| 1896 r. | - Herman Hollerith zakłada firmę Tabulating Machine Company | ||

| 1897 r. | - Karl Braun wynajduje lampę katodową | ||

| 1911 r. | - H.Hollerith sprzedaje swoją firmę, która łącząc się z inną tworzy firmę IBM | ||

| 1918 r. | - Dwóch wynalazców buduje maszynę liczącą wykorzystującą liczby w postaci zerojedynkowej | ||

| 1937 r. | - William Hewlett i David Packard zakładają firmę HP w garażu w Palo Alto w Kalifornii. Konrad Zuse produkuje pierwszy komputer używający kodu binarnego | ||

| 1938 r. | -Georges Stibitz i Samuel Wiliams budują Complex Number Computer, który zawiera 400 przekaźników telefonicznych i jest podłączony do trzech dalekopisów , prekursorów nowoczesnych terminali | ||

| 1944 r. | - Inżynierowie z Harvardu budują komputer MARK I ( na przekaźnikach ), ale wkrótce ulega on uszkodzeniu | ||

| 1946 r. | - Inżynierowie z Uniwersytetu Pensylwania demonstrują ENIAC -Electronic Numerical Integrator and Computer ,pierwszy elektroniczny komputer ogólnego zastosowania (zbudowany na lampach elektronowych - ok.18 tys. lamp, używał systemu dziesiątkowego, brak rozdziału między funkcjami liczenia i pamiętania, uciążliwe zewnętrzne programowanie ) | ||

| 1947 r. | - Dwóch pracowników Laboratorium Bella rozpoczyna eksperymenty z pierwszymi tranzystorami | ||

| 1949 r. | - John Mauchly wynajduje Short Code, pierwszy międzynarodowy język programowania wysokiego poziomu. | ||

| 1951 r. | - John Mauchly i John Eckert budują UNIVAC I, pierwszy komputer, zainstalowany w amerykańskiej instytucji zajmującej się spisami ludności. Grace Murray Hopper wynajduje translator AO, zamieniający kod programu w kod binarny (ASM-OBJ) | ||

| 1952 r. | - Wbrew panującym opiniom UNIVAC I przewiduje w wyborach prezydenckich przygniatające zwycięstwo prezydenta Eisenhowera nad Adlaiem Stevensonem | ||

| 1953 r. | -IBM produkuje komputer o nazwie 650, pierwszy wytwarzany masowo. Do czasu wycofania z rynku w 1969 r. sprzedano 1,5 tys sztuk | ||

| 1955 r. | -Naridner Kapany wynajduje włókno optyczne. American Airlains instalują utworzoną przez IBM pierwszą dużą sieć danych, łączącą 1,2 tys. dalekopisów | ||

| 1956 r. | - IBM opracowuje pierwszy twardy dysk, nazywany RAMAC. Programiści IBM tworzą język programowania FORTRAN. MANIAC I jest pierwszym komputerowym programem , który pokonał człowieka w grze w szachy. | ||

| 1958 r. | - Firma Texas Instruments buduje pierwszy układ scalony. Bell Telephone prezentuje pierwsze modemy. Naukowcy z Laboratorium Bella wynajdują laser. | ||

| 1959 r. | -Grace Murray Hopper i Charles Philips tworzą język programowania COBOL, Xerox wprowadza na rynek pierwszą komercyjną kopiarkę | ||

| 1960 r. | -Firma Digital Equipment Corporation tworzy PDP-1 , pierwszy komputer wyposażony w klawiaturę i monitor | ||

| 1962 r. | - Programiści z MIT tworzą pierwszą grę video | ||

| 1963 r. | - Pierwsza mysz opracowana przez Douglasa Engelbarta w Stanford Research Institute | ||

| 1964 r. | - American Standard Association decyduje, że kod ASCII będzie standardem transferu danych. | ||

| 1965 r. | -Digital Equipment Corporation buduje pierwszy mikrokomputer , który kosztuje 18000 dolarów. Zostaje stworzony uproszczony język programowania BASIC, który stanie się standardowym językiem programowania PC. | ||

| 1968 r. | - Powstaje firma Intel (po odłączeniu się grupy pracowników od koncernu Fairchild Semiconductor ). Po raz pierwszy komputer ( HAL 9000) bierze udział w filmie - jest to "2001 Odyseja kosmiczna" Stanleya Kubricka | ||

| 1969 r. | -Firma Honeywell wprowadza H316 "komputer do kuchni" -pierwszy komputer do domu (10600 $ -może m.in. planować menu ). Startuje ARPAnet prekursor Internetu | ||

| 1970 r. | -Wynaleziono dyskietkę. Intel prezentuje układ pamięci mogący przechowywać 1024 bity danych. Pierwsz komputerowa drukarka uderzeniowa. Laboratoria Bella tworzą system Unix | ||

| 1971 r. | - Firma Texas Instruments prezentuje pierwszy kieszonkowy kalkulator. Pojawiają się pierwsze drukarki igłowe. Niklaus Wirth tworzy język programowania Pascal. W Indiach powstaje pierwsze oprogramowanie rozpoznawania mowy -Hearsay | ||

| 1972 r. | -Ray Tomlinson wynajduje pocztę elektroniczną (e-mail) ATARI wprowadza "Pong" pierwszą grę komputerową. Laboratoria Bella tworzą język programowania C | ||

| 1975 r. | - Prezentacja pierwszego komputera osobistego Altair 8800 produkowanego przez firmę MITS z Albuquerque oraz pierwszego ekranu ciekłokrystalicznego . Firma Xerox wymyśla Ethernet. Powstaje pierwszy edytor tekstu Electric Pencil. IBM prezentuje drukarkę laserową. | ||

| 1976 r. | -Podczas National Computer Conference w Nowym Yorku firma Data General prezentuje procesory na.... pępku tancerki. Gary Kildall tworzy system CP/M a IBM pierwszą drukarkę atramentową,. Steve Wozniak i Steve Jobs zakładają Apple Computer - pierwszy złożony w garażu komputer Apple | ||

| 1977 r. | - Bill Gates i Paul Allen oficjalnie zakładają firmę Microsoft. Firma Apple wprowadza Aplle II -pierwszy montowany komputer osobisty ( aż do 1981 r- najchętniej kupowany komputer ) . Tandy i Commodore prezentują PC z wbudowanymi monitorami, które nie wymagają podłączenia to telewizora | ||

| 1978 r. | -Na rynek wchodzi WordStar, który wkrótce staje się najpopularniejszym edytorem tekstowym | ||

| 1979 r. | - Dan Bricklin i Bob Frankston prezentują graficzny kalkulator VisiCalc ( arkusz kalkulacyjny ) | ||

| 1980 r. | -Na rynku pojawia się dBase II | ||

| 1981 r. | - IBM prezentuje IBM PC z systemem operacyjnym MS-DOS .Rozpoczyna się wyścig pomiędzy firmami Apple i IBM. | ||

| 1982 r. | -Dr Barney Clark otrzymuje pierwsze sztuczne serce, którym steruje procesor. Pojawiają się odtwarzacze kompaktowe. Osborne buduje pierwszy komputer przenośny. Na rynek trafiają pierwsze klony komputera IBM . Magazyn "Time" przyznaje komputerowi nagrodę "Człowieka roku" | ||

| 1983 r. | - Ułożono pierwszy kabel optyczny między Bostonem, Nowym Yorkiem i Waszyngtonem. Apple prezentuje pierwszy komputer z graficznym interfejsem użytkownika i myszą o nazwie Lisa ( 9995 $ ) IBM rozpoczyna sprzedaż PC XT, który jako pierwszy ma wbudowany twardy dysk oraz prezentuje PCjr. | ||

| 1984 r. | - Pojawiają się pierwsze CD-ROMy . Apple wprowadza na rynek komputery Macintosh . Budowane są modemy o prędkości 2400 b. Hewlett-Packard reklamuje pierwszą osobistą drukarkę laserową LaserJet , a pisarz Wiliam Gibson tworzy termin "cyberprzestrzeń" | ||

| 1985 r. | -Zostaje założona America Online. Microsoft tworzy system Windows 1.0 dla IBM PC. W stanach Zjednoczonych pojawia się Nintendo | ||

| 1986 r. | - Microsoft wchodzi na giełdę. National Science Fundation zgadza się na utworzenie szkieletu Internetu | ||

| 1988 r. | - Microsoft prezentuje system Windows 2.03, którego okna przypominają okna Maca.Steve Jobs prezentuje NeXT. W internecie pojawia się samoreplikujący się program- wirus "Internet Worm" | ||

| 1989 r. | - Tim Berners Lee tworzy Sieć -World Wide Web. Xerox wytacza sprawę Apple o kradzież projekty graficznego interfejsu ( w 1979 r. Steve Jobs odwiedził zakłady Xerox) | ||

| 1990 r. | -Intel wprowadza procesor i486. Pojawia się Windows w wersji 3.0 | ||

| 1993 r. | -Wprowadzone zostają komputery PDA typu handheld . Intel wprowadza procesor Pentium . Mark Andreessen i Eric Bina projektują Mosaic, pierwszą graficzną przeglądarkę internetową. Zaprezentowany zostaje komputer Apple Newton | ||

| 1994 r. | -W USA staje się dostępny system nawigacji satelitarnej GPS. Intel sprzedaje 2 mln wadliwych Pentium. Firma Iomega prezentuje napęd Zip, Mark Andreessen pomaga założyć firmę Netscape | ||

| 1995 r. | - Pojawiają się monitory z płaskim ekranem . Microsoft prezentuje Windows 95 i wprowadza pakiet Office 95. Następuje standaryzacja technologii DVD. Jeffrey Bezos zakłada firmę Amazon.com, a Netscape wchodzi na giełdę. Powstaje wytworzony przez komputer pełnometrażowy film "Toy Story " | ||

| 1996 r. | - Urządzenia zewnętrzne pozwalają surfować po internecie przy pomocy telewizora | ||

| 1997 r. | - W USA dostępne są już pierwsze odtwarzacze DVD | ||

| 1998 r. | -Firma Diamond Multimedia wprowadza pierwszy odtwarzacz MP3. Apple wprowadza komputery w cukierkowych kolorach- iMac . Niebotycznie wzrastają ceny akcji serwisów Yahoo i Infoseek. Około 30 mln użytkowników dokonuje zakupów przez internet | ||

| 1999 r. | - Nadchodzą czasy darmowego systemu operacyjnego Linuks. AOL przejmuje Netscape'a. Microsoft osiąga zysk 14,48 mld dolarów | ||

| 2000 r. | - Panika spowodowana możliwością awarii - "błąd roku 2000" - na szczęście grubo przesadzona. Koło rozwoju "maszyn liczących" kręci się dalej |

góra strony

Generacje komputerów

|

|

|

||

| Generacja zerowa (1944-1946) | komputery zbudowane na przekaźnikach elektromechanicznych | ||

|

|

|

||

| Pierwsza generacja (1946-1959) | komputery budowane na lampach elektronowych, programowane w języku maszynowym | ||

|

|

|

||

| Druga generacja (1959-1965) | komputery budowane na tranzystorach, pierwsze systemy operacyjne, przetwarzanie z podziałem czasu, języki wysokiego poziomu | ||

|

|

|

||

| Trzecia generacja (1965-1975) | komputery budowane z wykorzystaniem układów scalonych, pierwsze mikroprocesory, zawartość pamięci wpisywana w procesie produkcyjnym | ||

|

|

|

||

| Czwarta generacja (1975- do dzisiaj) | komputery wykorzystujące układy scalone wielkiej skali integracji VLSI (Very Large Scale Integration ), zwiększenie pamięci, zwiększenie szybkości, produkcja masowa | ||

|

|

|

||

| Piąta generacja (cały czas prace badawcze) | wykorzystanie zjawiska nadprzewodnictwa, komputery kojarzące i uczące się na podstawie swoich doświadczeń ( sztuczna inteligencja ) |

- Możesz się łudzić, że jesteś lepszy od tych, którzy go jeszcze nie mają.

- Przestaniesz mieć problemy na co wydać pieniądze - aby iść z czasem i postępem - do komputera bez przerwy trzeba coś dokupować.

- Będziesz mieć pretekst by opuścić nudne imprezy rodzinne i towarzyskie.

- Rozwiniesz swoje zdolności manualne - w komputerze zawsze znajdzie się coś, co trzeba naprawić.

- Wreszcie komuś możesz bezkarnie nawymyślać, lub nawet przyłożyć pięścią.

- Będziesz mieć złudne poczucie, że jesteś nowoczesny.

- Jeśli zabezpieczysz dostęp hasłem - nie będziesz musiał się nim z nikim dzielić.

- Nauczysz się szpanersko brzmiących pojęć "komputerowych" .

- Przećwiczysz wielokrotnie swoją odporność nerwową .

- Możesz

się łudzić, że masz nad czymś władzę.

góra strony

HUMOR

10 powodów dla których należy mieć komputer